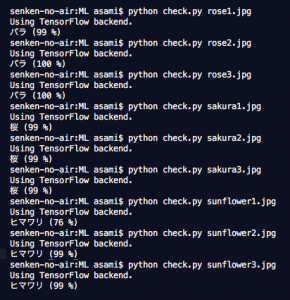

日経ソフトウェア」2017年11月号の記事にある「Tensorflow+Kerasによる機械学習」のフォローを終えました。「桜、バラ、ヒマワリ」の判別を基礎から勉強しました。手順は(1)写真共有サイトの「Flickr」を利用して、桜、バラ、ヒマワリの画像を300枚ずつ集める。(不適切な画像を取り除く「クリーニング」作業は今回省略)(2)画像を75×75ピクセルにリサイズしてNPZ形式に変換する。(3)画像を回転、左右反転などしてデータ数を18倍に増やす。(4)7割:学習用、3割:テスト用にデータを分けて、ニューラルネットワークを構築し、機械学習データを保存する。(5)未知の「桜、バラ、ヒマワリ」の画像の判別を行う。結果はバラ1:99%、バラ2:100%、バラ3:100%、桜1:99%、桜2:99%、桜3:99%、ヒマワリ1:76%、ヒマワリ2:99%、ヒマワリ3:99%の確率で、全て判別に成功しました。

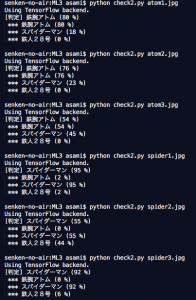

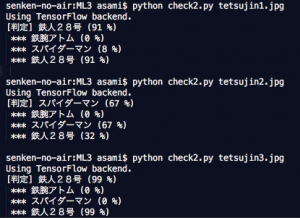

次に「鉄腕アトム」と「スパイダーマン」と「鉄人28号」のデータで、試してみました。ネットにあるデータが少ないので、それぞれ30個ずつになりました。データは左右対称と回転で18倍に増量しています。それぞれ3個ずつ、合計9個の未知のデータの判別で、1個だけ「鉄人28号」を「スパイダーマン」と間違えましたが、他は正解でした。(2017/11/23)

「日経ソフトウェア」2017年11月号

テスト1画像

テスト1結果

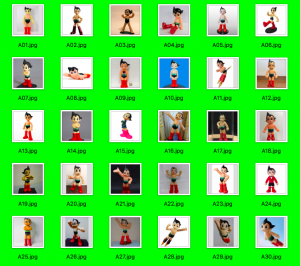

全データ「鉄腕アトム」

全データ「スパイダーマン」

全データ「鉄人28号」

テスト2画像

テスト2a結果

テスト2b結果

By t-asami •

AI研究 •